автор: Jes Scholz

Хотя параметры любимы разработчиками и поклонниками аналитики, они часто являются кошмаром для SEO. Бесчисленные комбинации параметров могут создать тысячи вариантов URL из одного и того же контента.

Проблема в том, что мы не можем просто пожелать, чтобы параметры исчезли. Они играют важную роль в пользовательском опыте на сайте. Поэтому нам нужно понимать, как обрабатывать их дружественным для SEO способом.

Чтобы сделать это, мы исследуем:

- Основы URL-параметров

- Проблемы SEO, вызванные параметрами

- Оценка степени вашей проблемы с параметрами

- Решения SEO для обуздания параметров

- Лучшая практика обработки URL-параметров

Что такое URL-параметры?

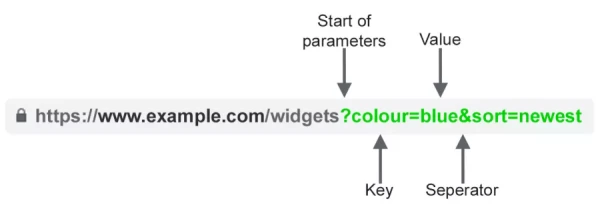

Также известные под псевдонимами query strings или переменные URL, параметры — это часть URL, следующая за знаком вопроса. Они состоят из пары ключ-значение, разделенной знаком равенства. Несколько параметров можно добавить на одну страницу, используя амперсанд.

Наиболее распространенными случаями использования параметров являются:

- Отслеживание — Например, ?utm_medium=социальный, ?sessionid=123 или ?affiliateid=abc

- Перестановка — Например, ?sort=низкая цена, ?порядок=самый высокий или ?со=новинка

- Фильтрация — Например, ?тип=виджет, цвет=синий или ?диапазон цен=20-50

- Идентификация — Например, ?продукт=маленький синий виджет, идентификатор категории=124 или идентификатор элемента=24AU

- Разделение на страницы — Например, ?страница=2, ?p=2 или viewItems=10-30

- Поиск — Например, ?запрос=пользователи-запрос, ?q=пользователи-запрос или ?поиск=вариант выпадающего списка

- Перевод — Например, ?lang=fr, ?язык=de или

Конечно, вот перевод текста:

SEO-проблемы с URL-параметрами

1. Параметры создают дублирующий контент

Часто URL-параметры не вносят существенных изменений в контент страницы. Отсортированная версия страницы часто отличается от оригинала лишь незначительно. URL страницы с метками отслеживания или идентификатором сессии идентичен оригиналу.

Например, следующие URL будут возвращать коллекцию виджетов.

- Статический URL: https://www.example.com/widgets

- URL с метками отслеживания: https://www.example.com/widgets?sessionID=32764

- URL с параметром сортировки: https://www.example.com/widgets?sort=последний

- URL с параметром идентификации: https://www.example.com?category=виджеты

- URL с параметром поиска: https://www.example.com/products?search=виджет

Это несколько URL для контента, который по сути является одним и тем же, — теперь представьте это для каждой категории на вашем сайте. Это может действительно накапливаться.

Проблема в том, что поисковые системы рассматривают каждый URL с параметрами как новую страницу. Таким образом, они видят несколько вариантов одной и той же страницы. Все они обслуживают дублирующий контент и нацелены на одну и ту же ключевую фразу или семантическую тему.

Хотя такое дублирование вряд ли приведет к тому, что ваш сайт будет полностью исключен из результатов поиска, оно приводит к каннибализации ключевых слов и может снизить восприятие Google общего качества сайта, поскольку эти дополнительные URL не добавляют никакой реальной ценности.

2. Параметры расходуют бюджет на краулинг

Краулинг ненужных страниц с параметрами затрачивает бюджет на краулинг, снижая способность сайта индексировать релевантные для SEO страницы и увеличивая нагрузку на сервер.

Google подводит итог этой точки зрения:

«Слишком сложные URL, особенно содержащие несколько параметров, могут создать проблемы для краулеров, создавая ненужно большое количество URL, указывающих на идентичный или похожий контент на вашем сайте. В результате Googlebot может потреблять гораздо больше пропускной способности, чем необходимо, или может быть не в состоянии полностью проиндексировать весь контент на вашем сайте».

3. Параметры разбавляют сигналы ранжирования страницы

Если у вас есть несколько вариантов одного и того же контента страницы, ссылки и публикации в социальных сетях могут поступать на разные версии.

Это разбавляет ваши сигналы ранжирования. Когда вы запутываете краулера, он становится неуверенным, какую из конкурирующих страниц следует индексировать для поискового запроса.

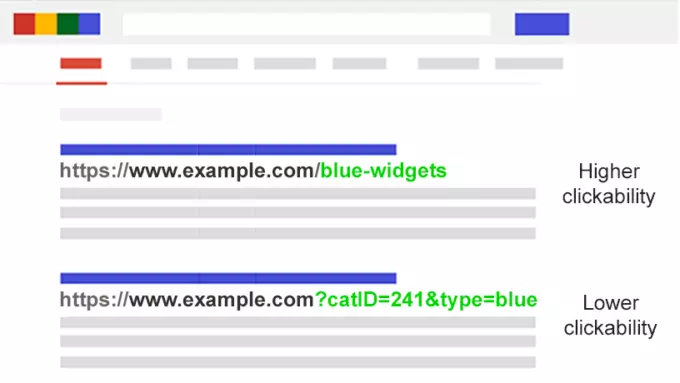

4. Параметры делают URL менее кликабельными

Давайте посмотрим правде в глаза. URL-параметры не очень привлекательны. Их трудно читать. Они не кажутся надежными. Поэтому они с меньшей вероятностью будут нажаты.

Это повлияет на производительность страницы. Не только потому, что CTR может влиять на рейтинги, но и потому, что на них менее нажимается в социальных сетях, в электронной почте, при копировании и вставке в форумы или где-либо еще, где отображается полный URL.

Хотя это может оказать лишь незначительное влияние на эффективность одной страницы, каждый твит, лайк, репост, электронное письмо, ссылка и упоминание имеют значение для домена.

Плохая читаемость URL может способствовать снижению вовлеченности бренда.

Оцените степень вашей проблемы с параметрами

Важно знать все параметры, используемые на вашем сайте. Но, скорее всего, ваши разработчики не ведут актуального списка.

Так как же найти все параметры, которые необходимо обработать? Или понять, как поисковые системы крадут и индексируют такие страницы? Понимая ценность, которую они приносят пользователям?

Следуйте этим пяти шагам:

- Запустите краулер: С помощью инструмента, такого как Screaming Frog, вы можете искать “?” в URL.

- Посмотрите в инструменте URL-параметров Google Search Console: Google автоматически добавляет найденные им запросы.

- Просмотрите свои журналы: Проверьте, крабит ли Googlebot URL-параметры.

- Поиск с использованием продвинутых операторов: Узнайте, как Google индексирует параметры, которые вы нашли, введя ключевое слово в комбинации site:example.com inurl:.

- Посмотрите в отчете Google Analytics All Pages: Ищите “?”, чтобы увидеть, как каждый из параметров, которые вы нашли, используются пользователями. Обязательно проверьте, что параметры URL-запросов не были исключены в настройках представления.

С этими данными вы можете теперь решить, как лучше всего обрабатывать каждый параметр вашего сайта.

SEO-решения для обуздания URL-параметров

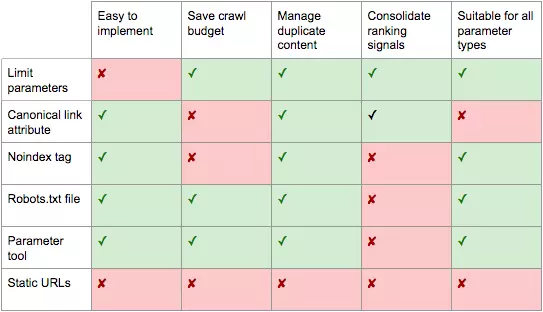

У вас в арсенале шесть инструментов для решения проблем с URL-параметрами на стратегическом уровне.

Ограничьте использование URL-параметров

Простой обзор того, как и почему генерируются параметры, может дать быстрый SEO-выигрыш. Вы часто обнаружите способы сокращения количества URL-параметров и, таким образом, минимизации негативного влияния SEO. Существуют четыре распространенные проблемы, с которых можно начать ваш обзор.

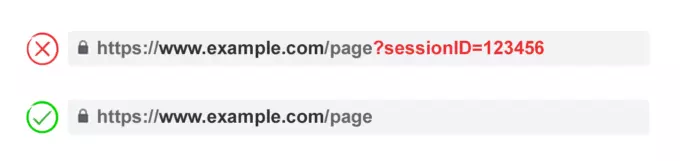

1. Устраните ненужные параметры

Спросите у разработчика список каждого веб-параметра и его функции. Вероятно, вы обнаружите параметры, которые больше не выполняют полезной функции.

Например, пользователи могут быть лучше идентифицированы с помощью файлов cookie, чем с помощью идентификаторов сессии. Однако параметр сессии может все еще присутствовать на вашем сайте, поскольку он использовался исторически.

Или вы можете обнаружить, что фильтр в вашей фасетной навигации редко используется пользователями.

Любые параметры, вызванные техническим долгом, должны быть немедленно устранены.

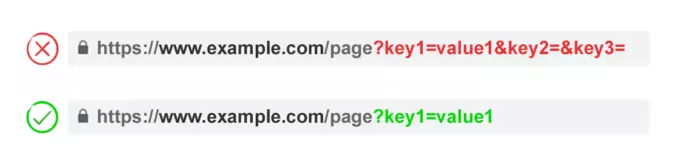

2. Предотвратите наличие пустых значений

URL-параметры должны добавляться в URL только тогда, когда они имеют функцию. Не допускайте добавления параметрных ключей, если значение пустое.

В приведенном выше примере ключ2 и ключ3 не имеют значения ни буквально, ни фигурально.

3. Используйте ключи только один раз

Избегайте применения нескольких параметров с одним и тем же параметром имени и разным значением.

Для вариантов выбора нескольких значений лучше объединить значения вместе после одного ключа.

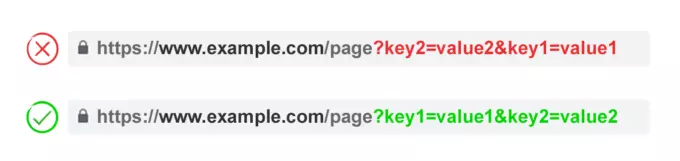

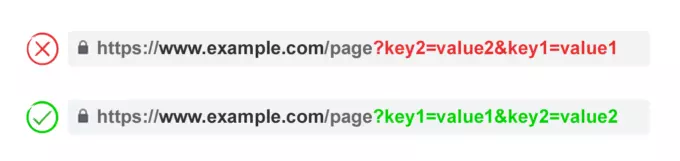

4. Упорядочите URL-параметры

Если один и тот же URL-параметр переставляется, страницы воспринимаются поисковыми системами как одинаковые.

Таким образом, порядок параметров не имеет значения с точки зрения дублирующего контента. Однако каждое из этих сочетаний расходует бюджет на краулинг и разделяет сигналы ранжирования страницы.

Избегайте этих проблем, попросив разработчика написать скрипт, который всегда располагает параметры в одинаковом порядке, независимо от того, как пользователь их выбирает.

На мой взгляд, вы должны начать с переводящихся параметров, затем с идентифицирующих, затем с параметрами сортировки, а затем с параметрами слоя, фильтрации, перестановки или поиска, и, наконец, с отслеживающими параметрами.

Преимущества:

- Позволяет более эффективное использование бюджета на краулинг.

- Снижает проблемы с дублирующим контентом.

- Консолидирует сигналы ранжирования на меньшее количество страниц.

- Подходит для всех типов параметров.

Недостатки:

- Требует умеренного времени на техническую реализацию.

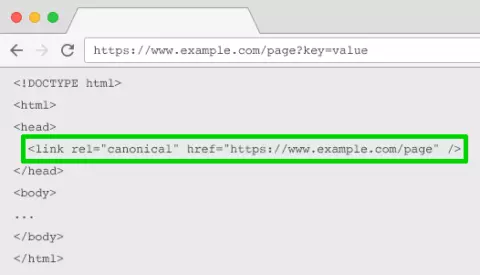

Атрибут ссылок rel=”canonical”

Атрибут ссылок rel=”canonical” указывает на то, что страница имеет идентичный или похожий контент на другую. Это побуждает поисковые системы объединять сигналы ранжирования на URL, указанный как канонический.

Вы можете использовать атрибут rel=”canonical” для ваших URL с параметрами, чтобы отслеживать, идентифицировать или переставлять параметры. Но эта тактика не подходит, когда контент на странице с параметрами недостаточно близок к каноническому, например, при пагинации, поиске, переводе или некоторых параметрах фильтрации.

Преимущества:

- Относительно простая техническая реализация.

- Вероятно, предотвратит проблемы с дублирующим контентом.

- Консолидирует сигналы ранжирования на канонический URL.

Недостатки:

- Расходует бюджет на краулинг страниц с параметрами.

- Не подходит для всех типов параметров.

- Интерпретируется поисковыми системами как сильный намек, а не директива.

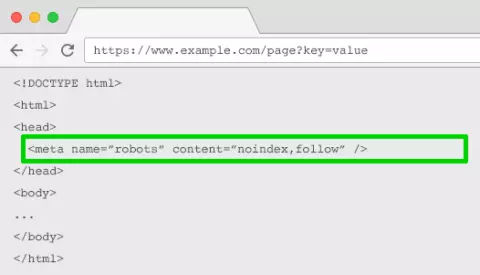

Мета-тег robots "noindex"

Установите директиву "noindex" для любой страницы, основанной на параметрах, которая не имеет ценности с точки зрения SEO. Этот тег предотвратит индексацию страницы поисковыми системами.

URL-адреса с тегом "noindex" также, вероятно, будут сканироваться реже, и если он присутствует в течение длительного времени, в конечном итоге приведет к тому, что Google применит атрибут "nofollow" к ссылкам на странице.

Преимущества:

- Относительно простая техническая реализация.

- Вероятно, предотвратит проблемы с дублирующим контентом.

- Подходит для всех типов параметров, которые вы не хотите индексировать.

- Удаляет существующие URL-адреса с параметрами из индекса.

Недостатки:

- Не предотвращает поисковые системы от сканирования URL-адресов, но побуждает их делать это реже.

- Не консолидирует сигналы ранжирования.

- Интерпретируется поисковыми системами как сильный намек, а не директива.

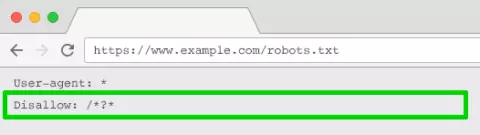

Robots.txt Disallow

Файл robots.txt — это то, что поисковые системы просматривают в первую очередь перед краулингом вашего сайта. Если они видят, что что-то запрещено, они даже не пойдут туда.

Файл robots.txt — это то, что поисковые системы просматривают в первую очередь перед краулингом вашего сайта. Если они видят, что что-то запрещено, они даже не пойдут туда.

Вы можете использовать этот файл для блокировки доступа краулера к каждому URL, основанному на параметрах (с помощью Disallow: /*?*), или только к определенным строкам запросов, которые вы не хотите индексировать.

Преимущества:

- Простая техническая реализация.

- Позволяет более эффективное использование бюджета на краулинг.

- Избегает проблем с дублирующим контентом.

- Подходит для всех типов параметров, которые вы не хотите краулить.

Недостатки:

- Не консолидирует сигналы ранжирования.

- Не удаляет существующие URL-адреса из индекса.

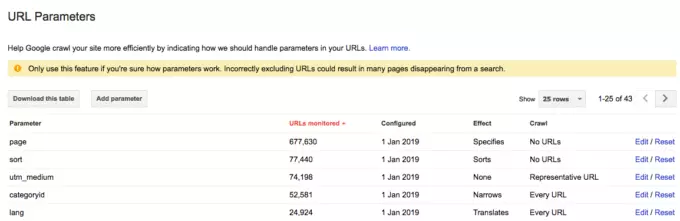

Инструмент обработки URL-параметров в Google Search Console

Настройте инструмент обработки URL-параметров Google Search Console, чтобы сообщить краулерам о цели ваших параметров и о том, как вы хотите, чтобы они обрабатывались.

Google Search Console содержит предупреждающее сообщение о том, что использование инструмента может привести к исчезновению многих страниц из поиска.

Это может показаться зловещим. Но что еще более пугающе, так это тысячи дублирующихся страниц, которые затрудняют способность вашего сайта ранжироваться.

Поэтому лучше всего научиться настраивать URL-параметры в Google Search Console, а не позволять Googlebotу решать.

Ключ заключается в том, чтобы задать себе вопрос о том, как параметр влияет на содержание страницы.

Параметры отслеживания не изменяют содержимое страницы. Настройте их как «представительские URL».

Настройте параметры, которые переупорядочивают содержимое страницы, как «сортирует». Если это необязательно, установите «No URLs» для краулинга. Если параметр по умолчанию является сортировкой, используйте «Только URL с значением», введя значение по умолчанию.

Настройте параметры, которые фильтруют страницу до подмножества содержимого, как «узкий». Если эти фильтры не имеют отношения к SEO, установите «No URLs» для краулинга. Если они имеют отношение к SEO, установите «Каждый URL».

Настройте параметры, которые отображают определенный фрагмент или группу содержимого, как «определяет». Желательно, чтобы это были статические URL. Если нет, вы, вероятно, захотите установить это на «Каждый URL».

Настройте параметры, которые отображают переведенную версию содержимого, как «переводит». Желательно, чтобы перевод осуществлялся с помощью подпапок. Если нет, вы, вероятно, захотите установить это на «Каждый URL».

Параметры конфигурации, которые отображают компонентную страницу более длинной последовательности, как «paginates». Если вы добились эффективной индексации с помощью XML-карт сайта, вы можете сэкономить бюджет на краулинг и установить «No URL» для краулинга. Если нет, установите «Каждый URL», чтобы помочь краулерам добраться до всех элементов.

Google автоматически добавит параметры в список под «Default», и вы не сможете их удалить, даже если параметр больше не существует.

Поэтому всякий раз, когда это возможно, лучше всего заранее добавить параметры самому. Так что, если в какой-то момент параметр перестанет существовать, вы можете удалить его из GSC.

Для любого параметра, который вы установите в Google Search Console на «No URL», вы также должны рассмотреть возможность добавления его в инструмент игнорирования URL-параметров Bing.

Преимущества:

- Не требует времени разработчика.

- Позволяет более эффективное использование бюджета на краулинг.

- Вероятно, предотвратит проблемы с дублирующим контентом.

- Подходит для всех типов параметров.

Недостатки:

- Не консолидирует сигналы ранжирования.

- Интерпретируется Google как полезный намек, а не директива.

- Работает только для Google и с меньшим контролем для Bing.

Переход от динамических к статическим URL

Многие люди считают, что оптимальный способ обработки URL-параметров — просто избегать их в первую очередь. В конце концов, подпапки превосходят параметры, помогая Google понять структуру сайта, а статические, ключевые URL-адреса всегда были краеугольным камнем на странице SEO.

Чтобы достичь этого, вы можете использовать серверные перенаправления URL для преобразования параметров в подпапки URL.

Например, URL:

www.example.com/view-product?id=482794

Станет:

www.example.com/widgets/blue

Этот подход хорошо работает для описательных URL-адресов, основанных на ключевых словах, таких как те, которые идентифицируют категории, продукты или фильтры для атрибутов, релевантных для поисковых систем. Он также эффективен для переведенного контента.

Но он становится проблематичным для несвязанных с ключевыми словами элементов фасетной навигации, таких как цена. Имея такой фильтр в качестве статического, индексируемого URL-адреса, не имеет никакой SEO-ценности.

Это также проблема для поисковых параметров, поскольку каждый пользовательский запрос будет создавать старую страницу, которая соревнуется за ранжирование с каноническим — или еще хуже представляет собой для краулеров страницы с низкокачественным контентом всякий раз, когда пользователь ищет товар, которого у вас нет.

Это немного странно, когда применяется к нумерации страниц (хотя и не является чем-то необычным из-за WordPress), которая дала бы URL:

www.example.com/widgets/blue/page2

Довольно странно для перестановки, которая дала бы URL:

www.example.com/widgets/blue/lowest-price

И часто не является жизнеспособным вариантом для отслеживания. Google Analytics не будет распознавать статическую версию UTM-параметра.

Более того, замена динамических параметров на статические URL-адреса для вещей, таких как нумерация страниц, результаты поиска на сайте или сортировка, не решает проблемы дублирующегося контента, бюджета краулера или разбавления внутренней ссылочной ценности.

И наличие всех возможных комбинаций фильтров из фасетной навигации в качестве индексируемых URL-адресов часто приводит к проблемам с тонким контентом. Особенно если у вас есть многозначные фильтры.

Многие специалисты по SEO утверждают, что можно обеспечить ту же пользовательскую работу, не влияя на URL. Например, используя POST-запросы вместо GET для изменения содержимого страницы. Таким образом, сохраняя пользовательский опыт и избегая проблем SEO.

Но удаление параметров этим способом удалило бы возможность для вашей аудитории закладывать или делиться ссылкой на конкретную страницу. И если это, очевидно, непрактично для отслеживания параметров и не является оптимальным для нумерации страниц.

Суть в том, что для многих веб-сайтов полное избегание параметров просто невозможно, если вы хотите предоставить идеальный пользовательский опыт. И это не лучший вариант с точки зрения SEO.

Таким образом, мы остаемся с этим. Для параметров, которые вы не хотите, чтобы их индексировали в результатах поиска, реализуйте их в виде строковых параметров запроса. Для параметров, которые вы хотите, чтобы их индексировали, используйте статические пути URL.

Преимущества:

- Переносит фокус краулера со параметров URL на статические URL, которые имеют более высокую вероятность ранжирования.

Недостатки:

- Требует значительных затрат времени на разработку URL-перезаписи и 301-перенаправления.

- Не решает проблемы дублирующегося контента.

- Не консолидирует сигналы ранжирования.

- Не подходит для всех типов параметров.

- Может привести к проблемам с тонким контентом.

- Не всегда обеспечивает ссылкуемый или сохраняемый URL.

Лучшая практика обработки URL-параметров для SEO

Так что же из этих шести тактик SEO вам следует реализовать?

Ответ не может быть все сразу.

Не только это создаст ненужную сложность, но и часто решения SEO активно конфликтуют друг с другом.

Например, если вы реализуете блокировку в robots.txt, Google не сможет увидеть никакой мета-тег noindex. Вы также не должны комбинировать мета-тег noindex с атрибутом ссылки rel=canonical.

Что становится ясным, так это то, что нет одного идеального решения.

Даже Джон Мюллер из Google не может определиться с подходом. В Google Веб-мастерском вебинаре он изначально рекомендовал избегать блокировки параметров, но когда его спросили об этом с точки зрения фасетной навигации, он ответил: «Это зависит».

Есть случаи, когда эффективность краулинга важнее, чем объединение сигналов ранжирования.

В конечном итоге, что подходит для вашего сайта, будет зависеть от ваших приоритетов.

Лично я не использую noindex или блокировку доступа к страницам с параметрами. Если Google не может краулить и понимать все переменные URL, он не может объединить сигналы ранжирования на канонической странице.

Я принимаю следующий план действий для обработки URL-параметров, дружественных к SEO:

- Провожу исследование ключевых слов, чтобы понять, какие параметры должны быть дружественными к поисковым системам, статическими URL.

- Реализую правильную обработку нумерации с использованием rel=»next & rel=»prev».

- Для всех оставшихся URL-параметров, основанных на параметрах, реализую последовательные правила упорядочения, которые используют ключи только один раз и предотвращают пустые значения, чтобы ограничить количество URL.

- Добавляю атрибут ссылки rel=canonical на подходящие страницы с параметрами, чтобы объединить их способность ранжирования.

- Настраиваю обработку URL-параметров как в Google, так и в Bing как дополнительную меру предосторожности, чтобы помочь поисковым системам понять функцию каждого параметра.

- Проверяю дважды, чтобы убедиться, что никакие URL-параметры не включены в XML-карту сайта.

Независимо от выбранной стратегии обработки URL-параметров, убедитесь, что вы документировали влияние ваших усилий на KPI, чтобы можно было измерить их эффективность.